Robots文件:网站Robots.txt设置Robots协议该怎么写,看这(4)

2023-03-09 来源:你乐谷

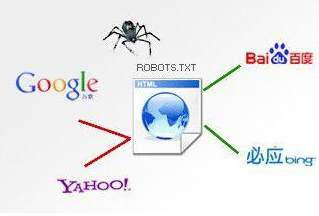

最后我们再聊聊Robots协议究竟该怎么写

Robots协议怎么写,其实我们在网上简单的了解一下也会学会了,这面有三个必要重要的书写开头“User-agent: ”、“Disallow: ”、“Allow: ”。User-agent:是用来定义Robots文件的,一般书写为User-agent: *即可,另两个我们在上一段已经说过是什么作用了,所以在这里我们直接说如何使用,例如我想禁止某个页面或者某个目录被搜索引擎抓取,我就可以书写为“Disallow: xxx.com/xxx/x.html”或者“Disallow: /admin/”。而“Allow: ”的运用其实也是这种意思,例如上面说到的淘宝网,他就是把大部分页面都使用Robots协议做了屏蔽,而只允许了某一个或者某一些页面允许抓取,所以他就只需要在Robots.txt写入“Allow:某个页面或者某些页面的网站根目录 ”的Robots协议即可。

Robots协议写法

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

写到最后

好了今天关于网站的Robots文件就写到这里了,希望这篇文章对你有所帮助,当然了如果大家遇到什么关于Robots协议该怎么写的问题也可以在下面的留言处给我留言,我会在看到的第一时间回复给大家的,好了今天66分享网(六六站长)继续研究下一篇文章该跟大家讲讲那些知识了。

岛国番号库网站

岛国番号库网站